SICHERHEIT

Megatrend Sicherheit

| February 4, 2025

Sicherheit unterliegt einem ständigen Wandel und wird sehr individuell wahrgenommen. Gleich in welcher Ausformung, ist das Streben nach Sicherheit..

Glossar Sicherheit: Trendbegriffe und Definitionen

| January 31, 2025

A, B Autonomes Fahren Hochautomatisierte Fahrsituationen wie Einparken oder Stauassistenten markieren die Übergangsphase zum autonomen Fahren, das..

Die Megatrends

| December 31, 2024

Was sind Megatrends Megatrends – Definition Wie unterscheiden sich Megatrends von anderen Trends? Wie entstehen Megatrends? 11 Megatrends – Die..

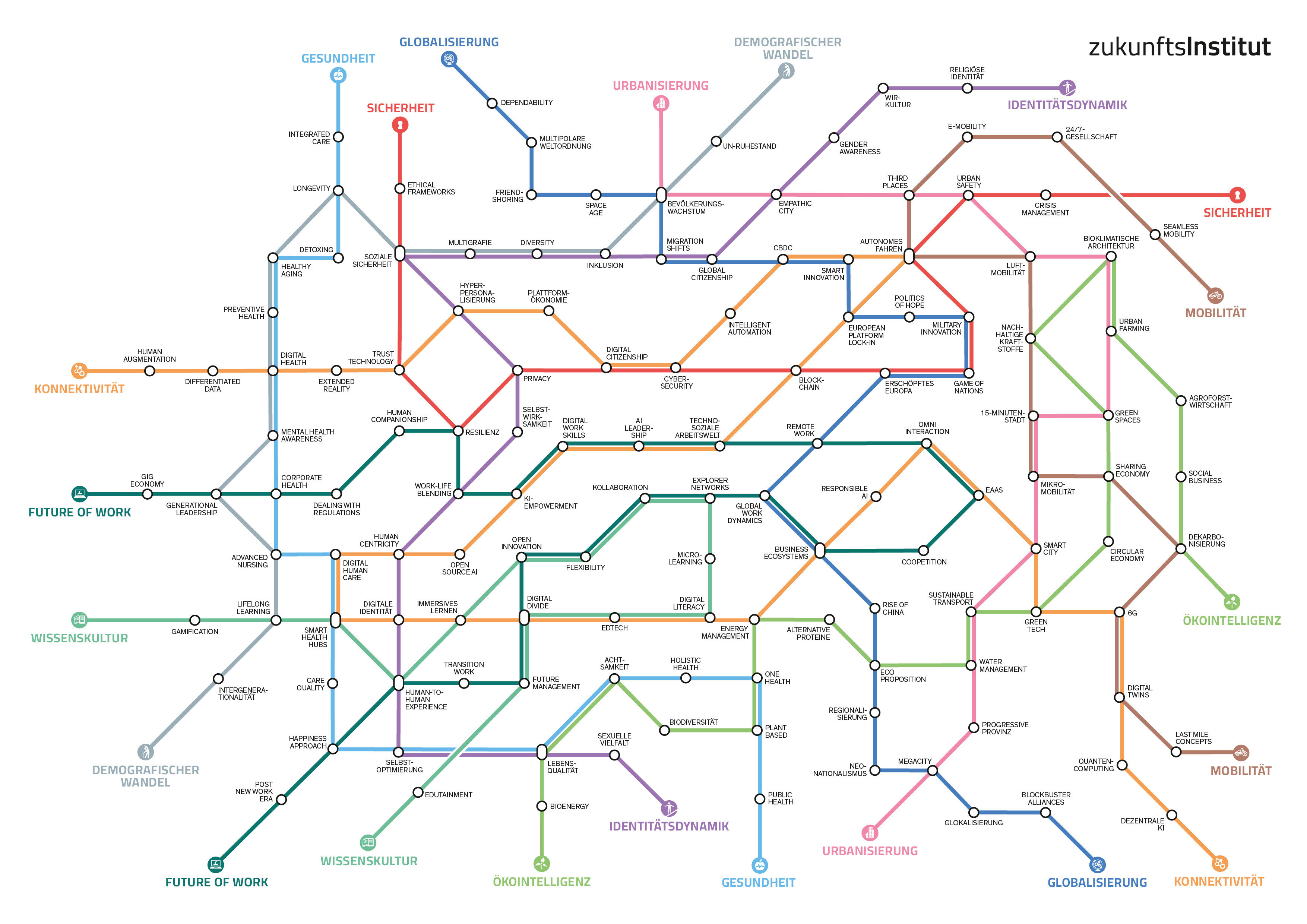

Die Megatrend-Map

| March 12, 2024

Die Megatrend-Map zeigt die 11 zentralen Megatrends unserer Zeit. Sie sind die größten Treiber des Wandels in Wirtschaft und Gesellschaftund prägen..

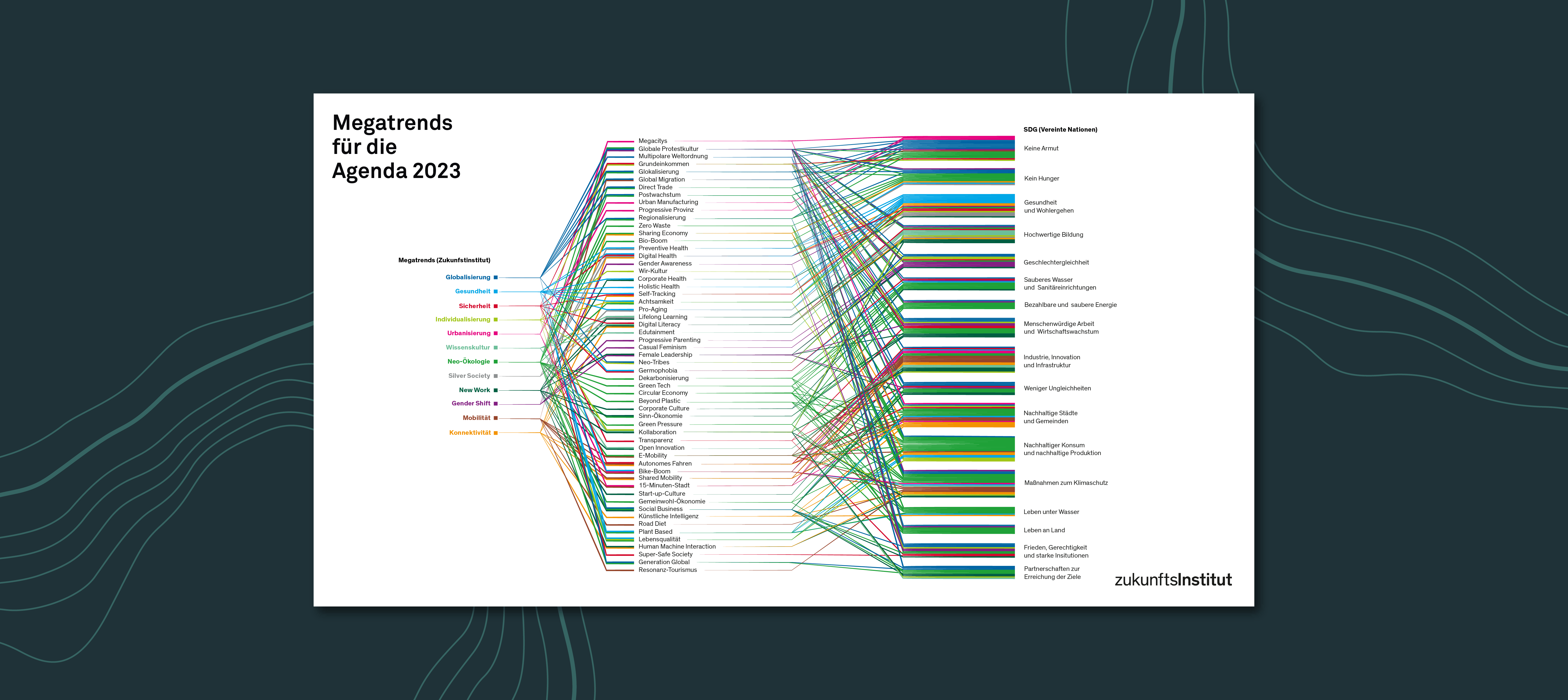

Megatrends meets SDG: Treiber für Nachhaltigkeit

| December 16, 2023

Ein freies und friedliches Leben in Wohlstand auf einem gesunden Planeten für alle Menschen: Um diese Vision einer resilienten Weltgemeinschaft im..

Keine Angst vor Tools!

| December 15, 2023

Es gibt viele Kompetenzen, die wir im 21. Jahrhundert neu entdecken und erlernen müssen. Paradoxie-Kompetenz zum Beispiel: der Umgang mit extrem..

Das Potenzial der Megatrends für Strategie und Management

| June 3, 2022

Die Dynamik des Wandels prägt immer mehr Bereiche in Wirtschaft und Gesellschaft. Sämtliche Branchen und selbst so starre Institutionen wie die..

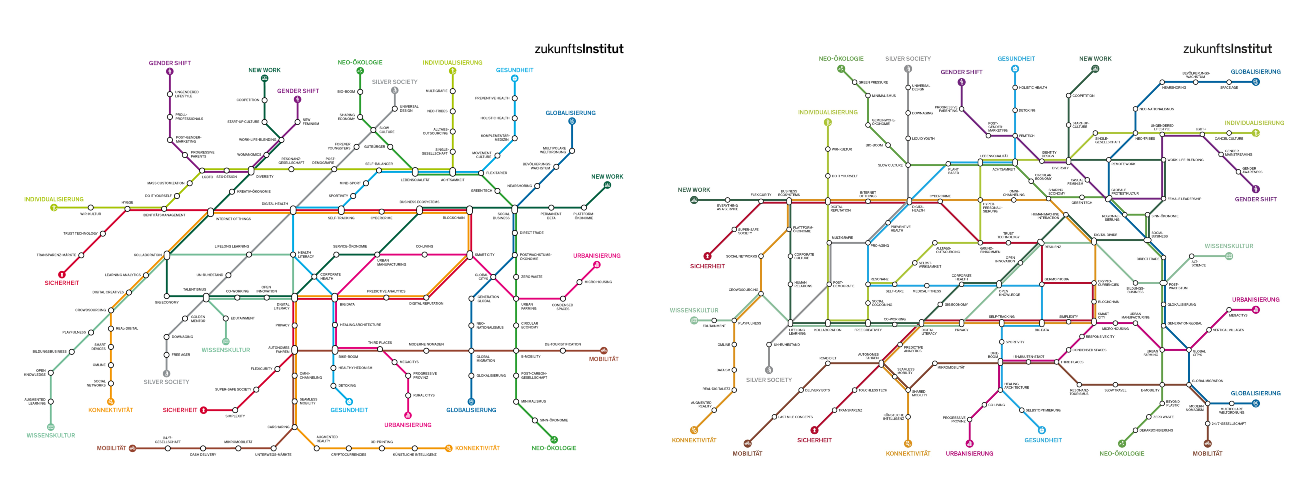

Die Pandemie sorgt für Verschiebungen auf der Megatrend-Map

| December 3, 2021

Die Erfahrungen der Corona-Pandemie zeigen ihre Auswirkungen, ebenso wie in der aktuellen Megatrend-Dokumentation, auch auf der aktuellen..

"Der Cyberkrieg ist längst hier"

| December 4, 2020

Frau Dunn Cavelty, Sie haben sich intensiv mit dem Thema Cyberwar auseinandergesetzt. Zu welchen Ergebnissen sind Sie gekommen? Werden sich die..

Wie um die Megatrends gesellschaftlicher Wandel entsteht

| September 3, 2020

Wie kommt es zu gesellschaftlichem Wandel und Umbrüchen? Dieser Frage geht die Trend- und Zukunftsforschung nach, wenn sie aus Megatrends Aussagen..

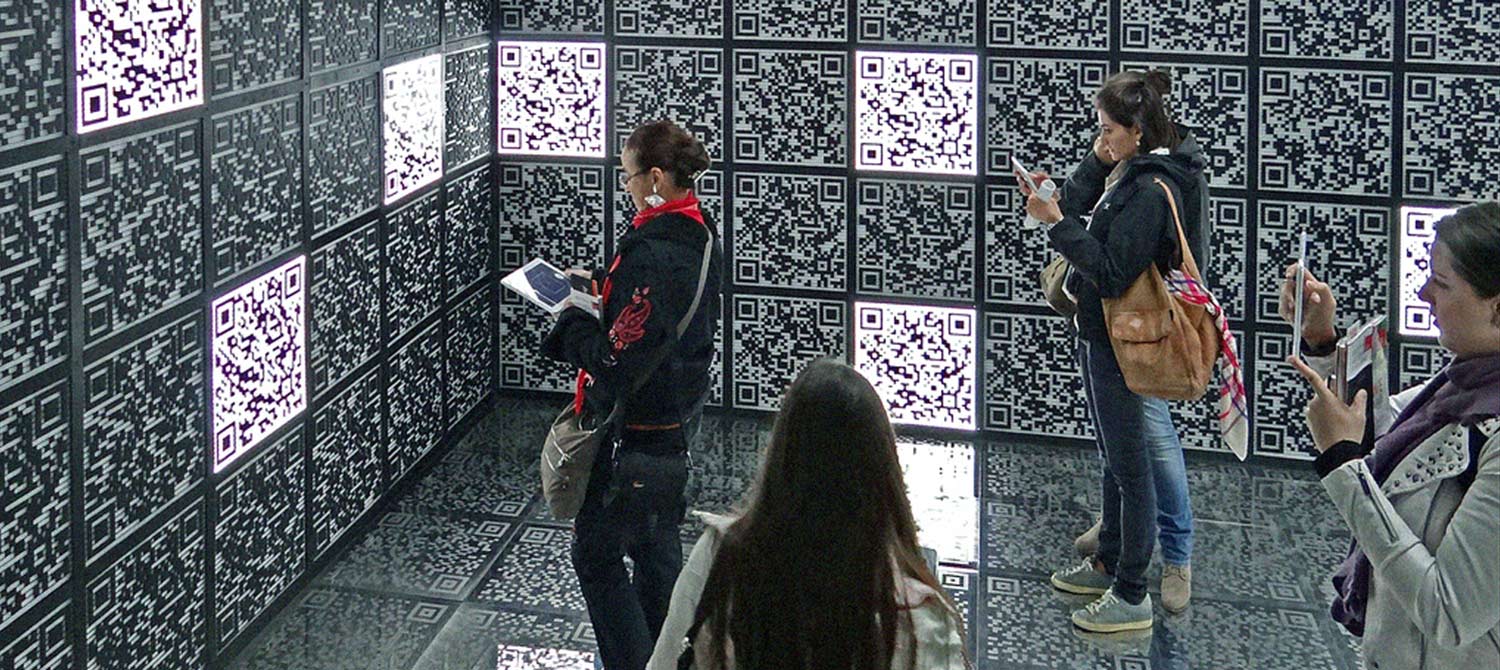

Beim Hacken geht es um das Lernen

| December 3, 2019

Was summiert man unter dem Begriff des Hackers? “Den” Hacker gibt es nicht. Das Problem mit diesem Begriff ist, dass er unheimlich breit angelegt..

Dem Verbrechen auf der Datenspur

| December 16, 2016

Verbrechen vereiteln, bevor sie entstehen. Schon vorab wissen, wo gleich eine Straftat begangen wird. Was nach einer Science-Fiction-Vision à la..

ERLEBEN SIE ZUKUNFT

Unser Team berät Sie gerne und vermittelt Ihnen die Experts, die Ihrer Organisation Zukunft passgenau näher bringen. Wir freuen uns, gemeinsam das perfekte Vortragsthema, das ideale Format und den besten Speaker für Sie zu finden. Kontaktieren Sie uns einfach über das folgende Formular: