DIE ZUKUNFT IST EIN HANDLUNGSRAUM

Unser Blog ist ein Treffpunkt für alle, die sich aktiv an der Formung unserer Zukunft beteiligen wollen. Hier wird die Zukunft nicht als ferne Unbekannte behandelt, sondern als ein Handlungsraum, den wir gemeinsam gestalten und erforschen.

Trendradar Megatrend Mobilität

| April 29, 2025

Das Trendradar aus der Megatrendstudie Mobilität – entstanden in strategischer Partnerschaft mit Norton Rose Fulbright – liefert Ihnen einen..

Glossar Urbanisierung: Trendbegriffe und Definitionen

| February 6, 2025

15-Minuten-Stadt Ein urbanes Konzept, das alle wichtigen Einrichtungen des täglichen Lebens innerhalb von 15 Minuten zu Fuß oder mit dem Fahrrad..

Glossar Sicherheit: Trendbegriffe und Definitionen

| January 31, 2025

A, B Autonomes Fahren Hochautomatisierte Fahrsituationen wie Einparken oder Stauassistenten markieren die Übergangsphase zum autonomen Fahren, das..

Der CEO der Zukunft ist eine KI

| November 13, 2024

Wo vermuten Sie die Zukunft ? Prof. Dr. Dirk Stein: Im digitalen Raum aus meiner Sicht insbesondere in KI-Assistenten. Die Digitalisierung hat uns..

Die 13 Leitsätze für 2025

| November 13, 2024

Unsere Zukunft ist von zunehmender Komplexität und Ungewissheit geprägt. Unterschiedlichste Einflüsse erschweren es uns, eine klare Sicht auf die..

Megatrendstudie Konnektivität: Die neue menschzentrierte Vernetzung

| August 28, 2024

Bereits bei vorangegangen Research-Prozessen, sowohl im Rahmen unserer Megatrend-Forschung als auch in Kund:innenprojekten, zeigte sich die prägende..

Konnektivität Trend Human Centricity

| August 28, 2024

Human Centricity rückt den Menschen in den Mittelpunkt der technologischen Gestaltung und geht dabei weit über die bloße Verbesserung der..

Konnektivität Trend AI Leadership

| August 28, 2024

AI Leadership beschreibt den aufstrebenden Trend, Künstliche Intelligenz (KI, englisch Artificial Intelligence, AI) zur Unterstützung von..

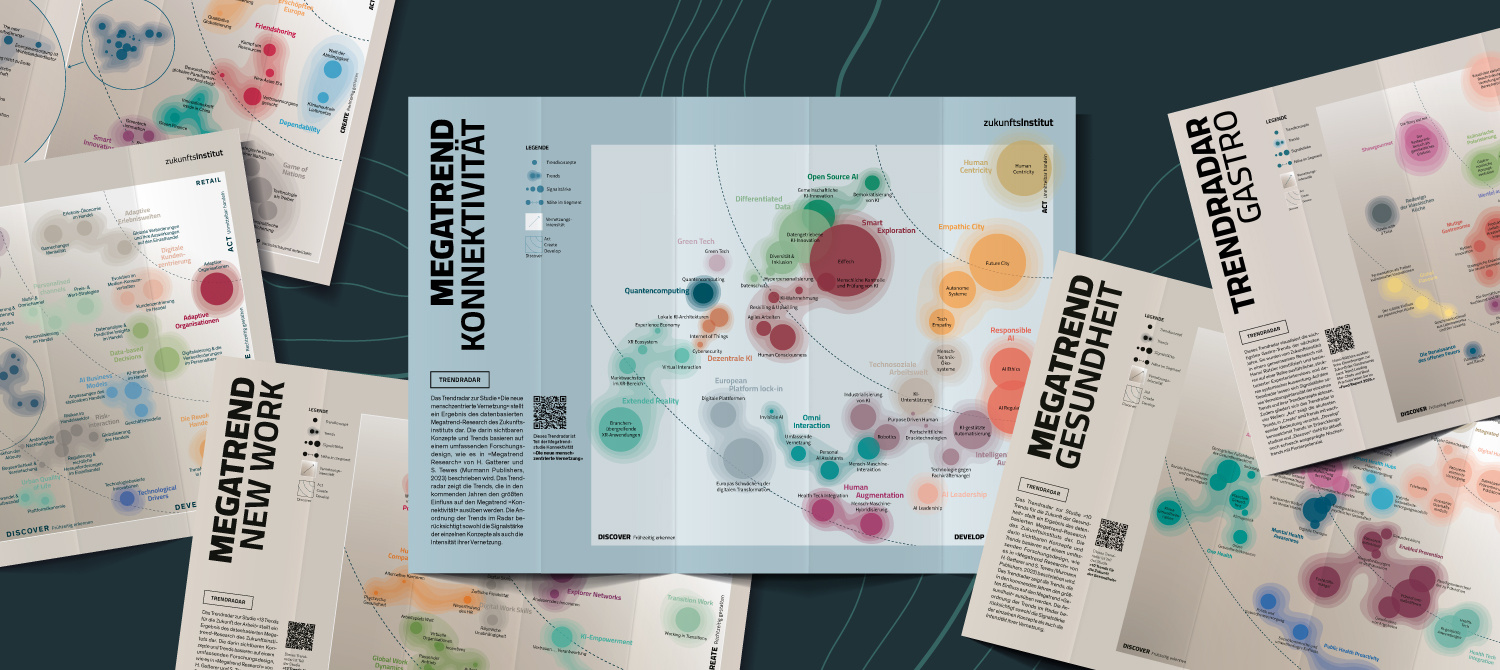

Trendradar Megatrend Konnektivität

| August 22, 2024

Das Trendradar aus der Megatrendstudie Die neue menschzentrierte Vernetzung stellt ein Ergebnis des datenbasierten Megatrend-Research des..

Around Supermarkets – Gesunder und nachhaltiger Konsum

| June 10, 2024

Im digitalen Zeitalter hat sich unser Einkaufsverhalten stark verändert. Während Supermärkte und Discounter weiterhin dominieren, erleben alternative..

Food Trends 2025: Was und wie wir in Zukunft essen werden

| June 10, 2024

Food Trends sind keine statischen Phänomene, sie befinden sich in einer permanenten Evolutionsschleife. Sie verstärken oder präzisieren sich,..

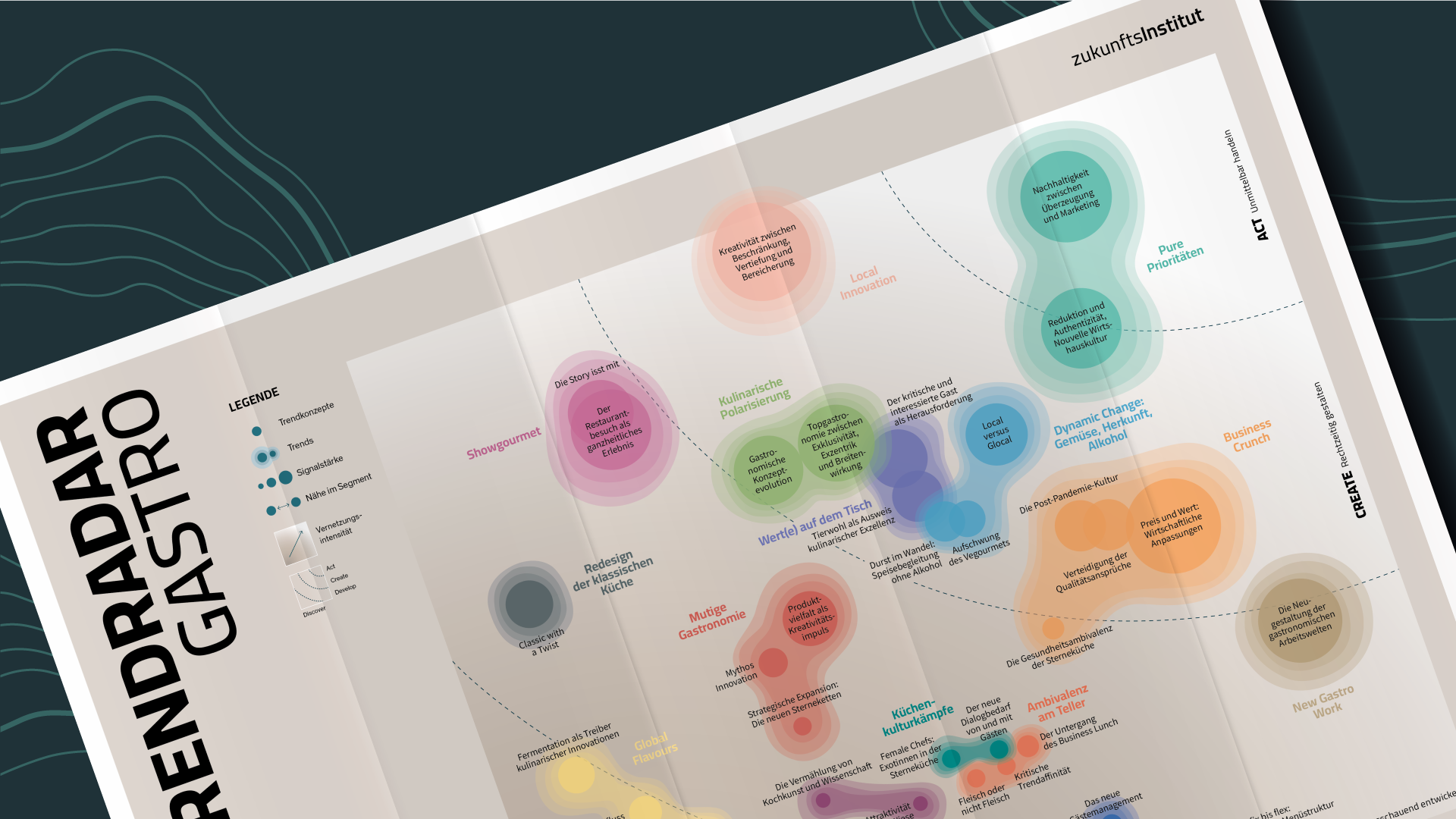

Die stärksten Trends und Trendkonzepte in der Topgastronomie

| June 10, 2024

Die Gastronomiebranche befindet sich in einem ständigen Wandel, und wer an der Spitze bleiben möchte, muss die neuesten Trends und Entwicklungen..

Trendradare im Überblick

| May 16, 2024

Mobilität In der Mobilität ist vieles in Bewegung – nicht nur physisch, sondern auch strukturell, gesellschaftlich und technologisch. Die 14..

Prof. Dr. Matusiewicz über die Zukunftsgestaltung im Gesundheitswesen

| May 10, 2024

Das Interview führte Gregor Kroismayr, Qualitative Research Analyst beim Zukunftsinstitut. Gregor Kroismayr: Vielen Dank für Ihre Zeit, Herr..

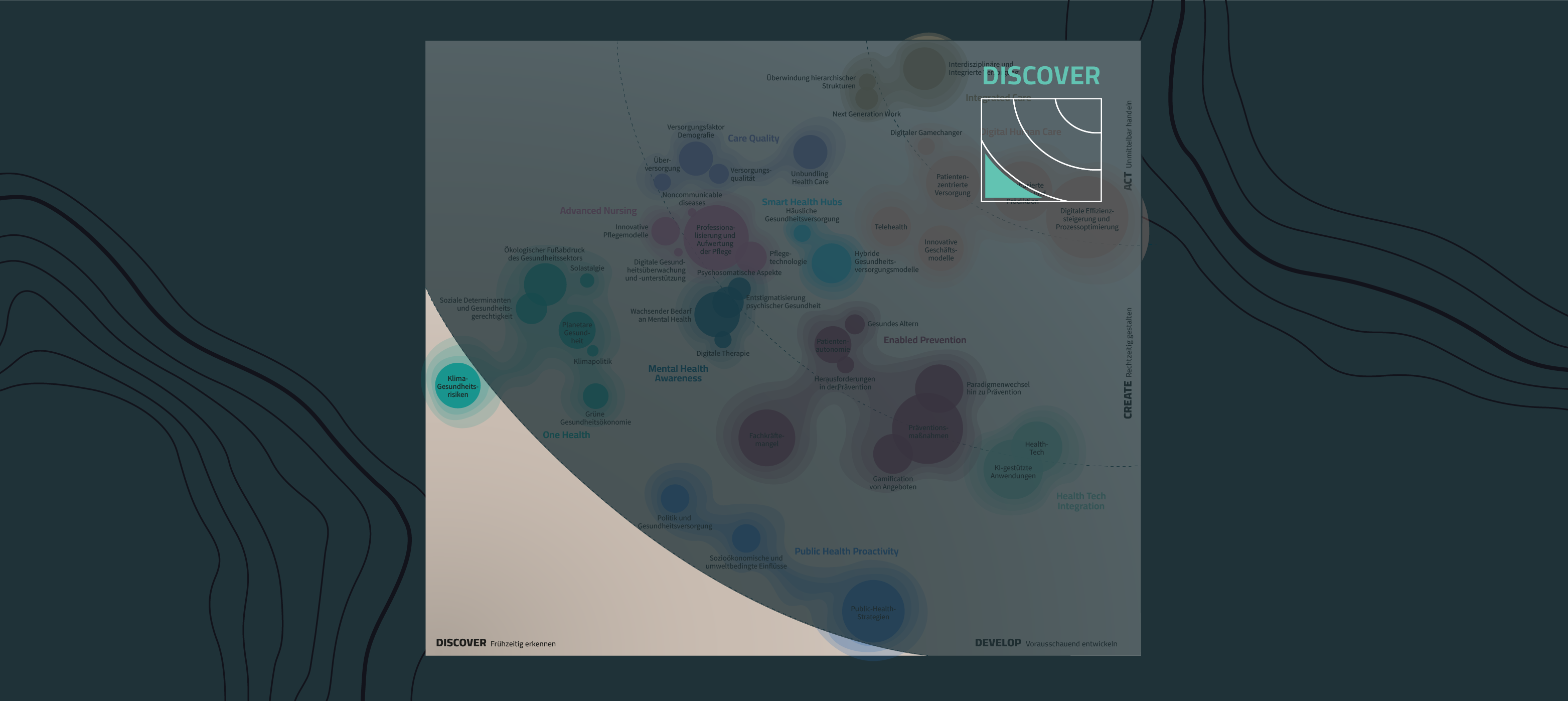

Discover: Pionierpotenziale in der Gesundheitsbranche

| May 7, 2024

Die Trends in der Welle „Discover“ sind noch sehr schwach ausgeprägt, bieten aber schon Pionierpotenzial. Daher gilt es, diese bereits zu kennen, um..

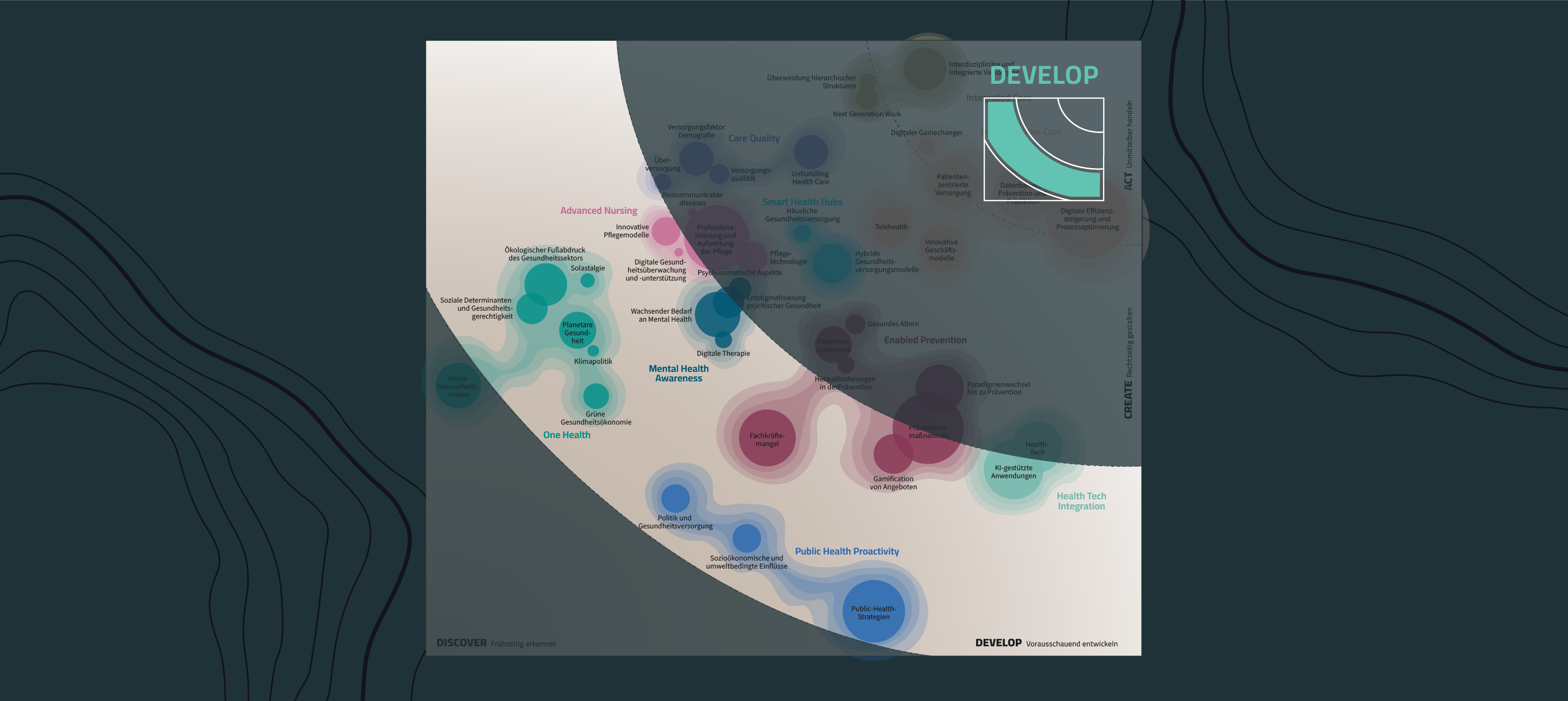

Develop: Gesundheitstrends vorausschauend strategisch nutzen

| May 7, 2024

Trends in der dritten Radarwelle „Develop“ sind Trends, die sich noch in einem Entwicklungsstadium befinden. Diese gilt es vorausschauend auf dem..

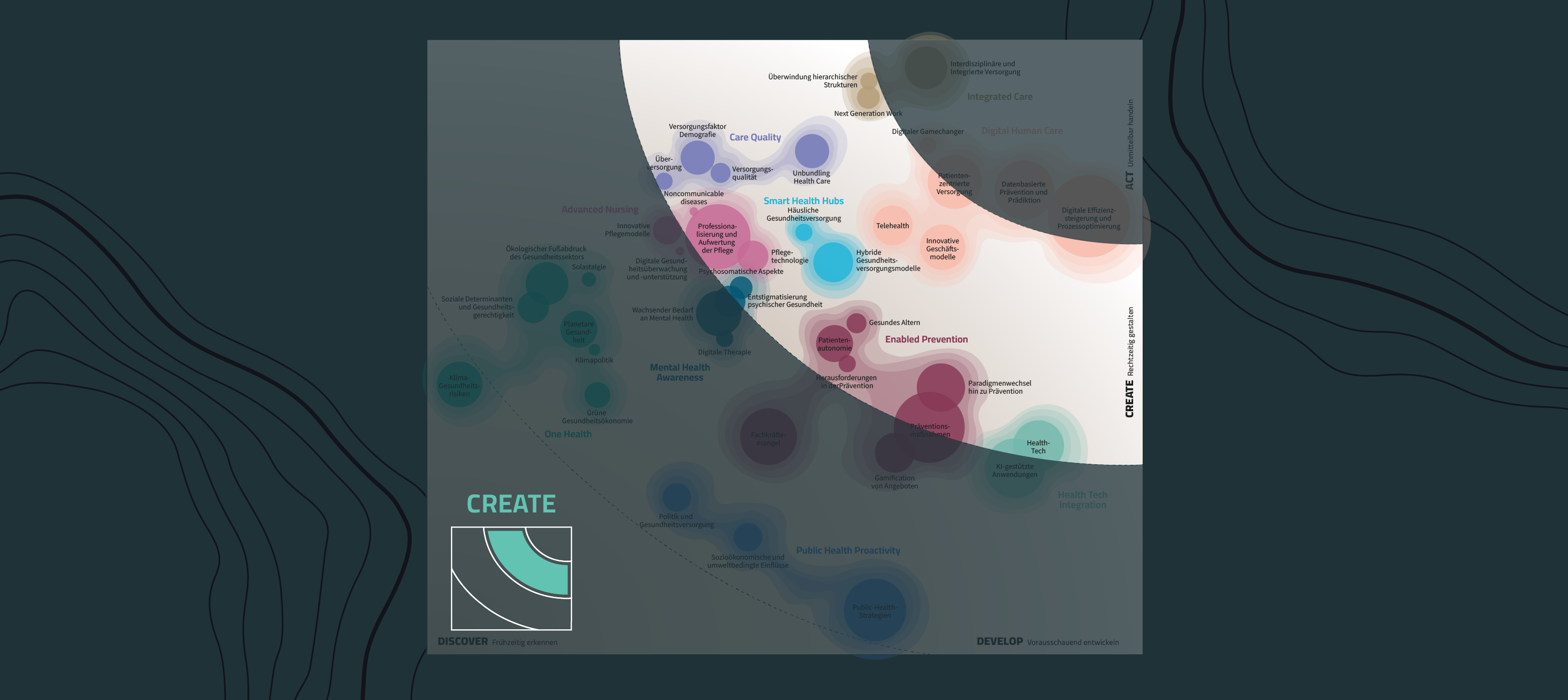

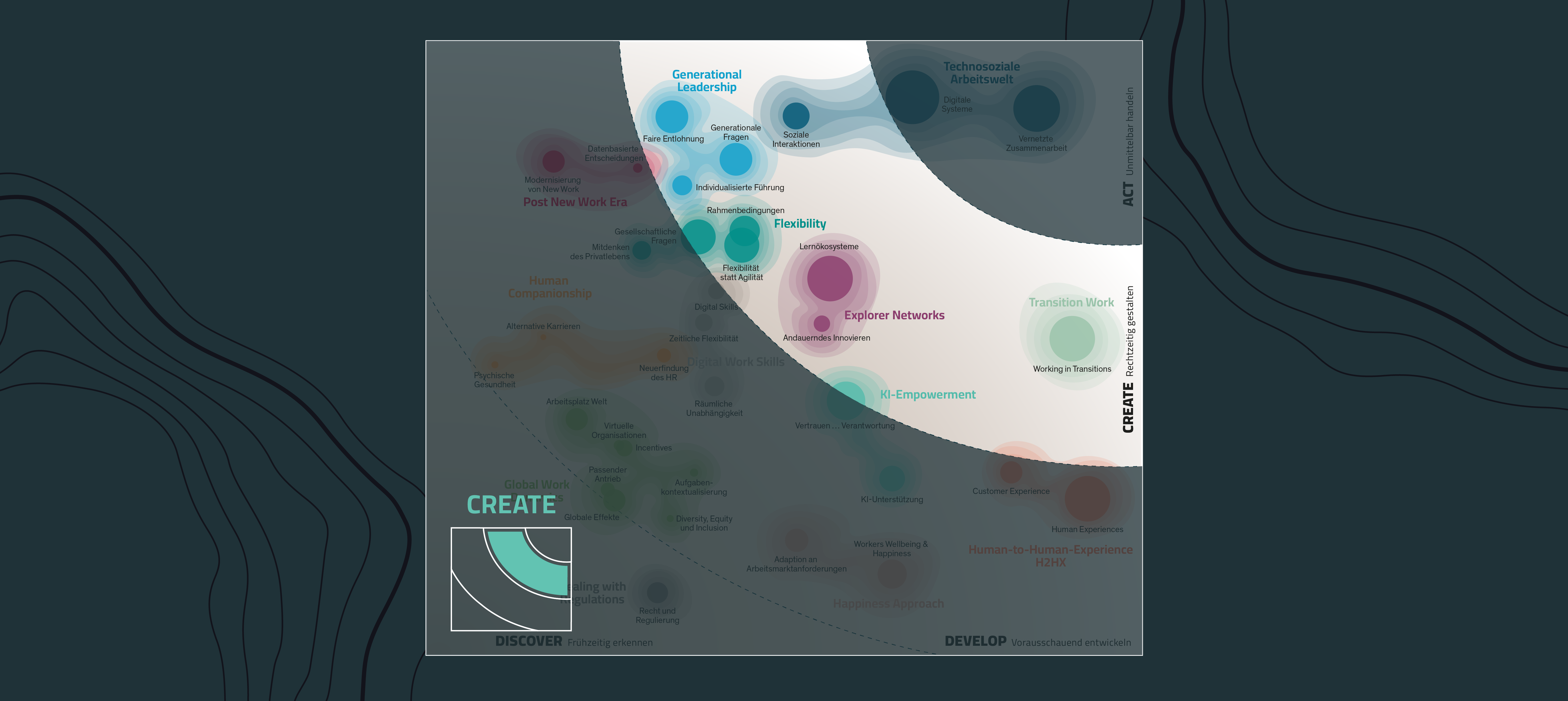

Create: Für welche Gesundheitstrends Sie Maßnahmen gestalten sollten

| May 7, 2024

Trends in der zweiten Radarwelle „Create“ sind Trends, bei denen bereits ersichtlich ist, dass sie in den nächsten Jahren zunehmend wirken werden...

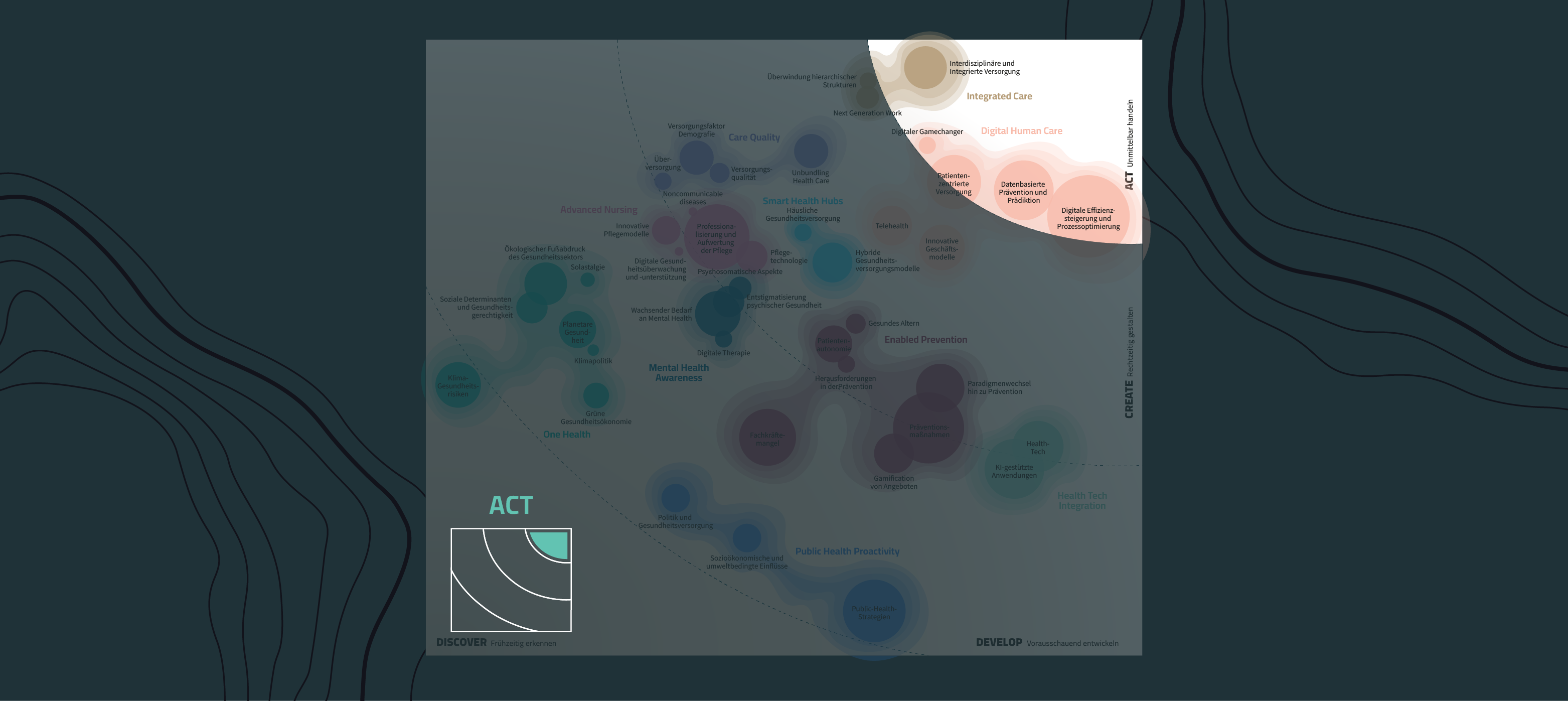

Act: Für welche Gesundheitstrends Sie jetzt reagieren müssen

| May 7, 2024

Trends in der ersten Radarwelle „Act“ sind Trends, mit denen Sie sich jetzt akut auseinandersetzen und in die Sie investieren sollten. Im Falle des..

Trendradar Gesundheit: Zukunft der Gesundheit im Überblick

| April 30, 2024

Das Trendradar aus der Megatrendstudie 10 Trends für die Zukunft der Gesundheit stellt ein Ergebnis des datenbasierten Megatrend-Research des..

Megatrendstudie Gesundheit: 10 Gesundheitstrends der kommenden Jahre

| April 30, 2024

Die im Rahmen der Forschung zum Megatrend Gesundheit vom Zukunftsinstitut identifizierten zehn Gesundheitstrends zeigen eine wachsende Integration..

Plant-Based Food – Synergien für ganzheitliche Lösungen

| April 5, 2024

Was ist plant-based Food Zu Plant-based Food gehören Lebensmittel, die aus verarbeiteten pflanzlichen Rohstoffen wie extrahiertem Soja, Erbsen,..

Future Business Guide KI Empowerment

| March 26, 2024

Unternehmen erfahren zunehmend Druck, sich mit Künstlicher Intelligenz (KI) auseinanderzusetzen, besonders nach dem bedeutenden Wachstum im Jahr 2023..

New Work - KI Empowerment: Künstliche Intelligenz als Teil der Vision

| March 19, 2024

In der heutigen, sich schnell wandelnden Digitalära wird ein entscheidender Trend immer deutlicher, der einen tiefgreifenden Einfluss auf die Art und..

Zukunftsforschung im 21. Jahrhundert: Erkenntnisse und Methoden

| March 19, 2024

Die Zukunftsforschung im Umbruch Die Zukunftsforschung, einst geprägt von linearen Prognosen und spekulativen Annahmen, befindet sich mitten in einer..

Megatrendstudie: 13 Trends für die Zukunft der Arbeit

| March 12, 2024

Die Studie „13 Trends für die Zukunft der Arbeit“ entfaltet eine visionäre Karte der Kräfte, die die Landschaft von New Work neu gestalten. Durch..

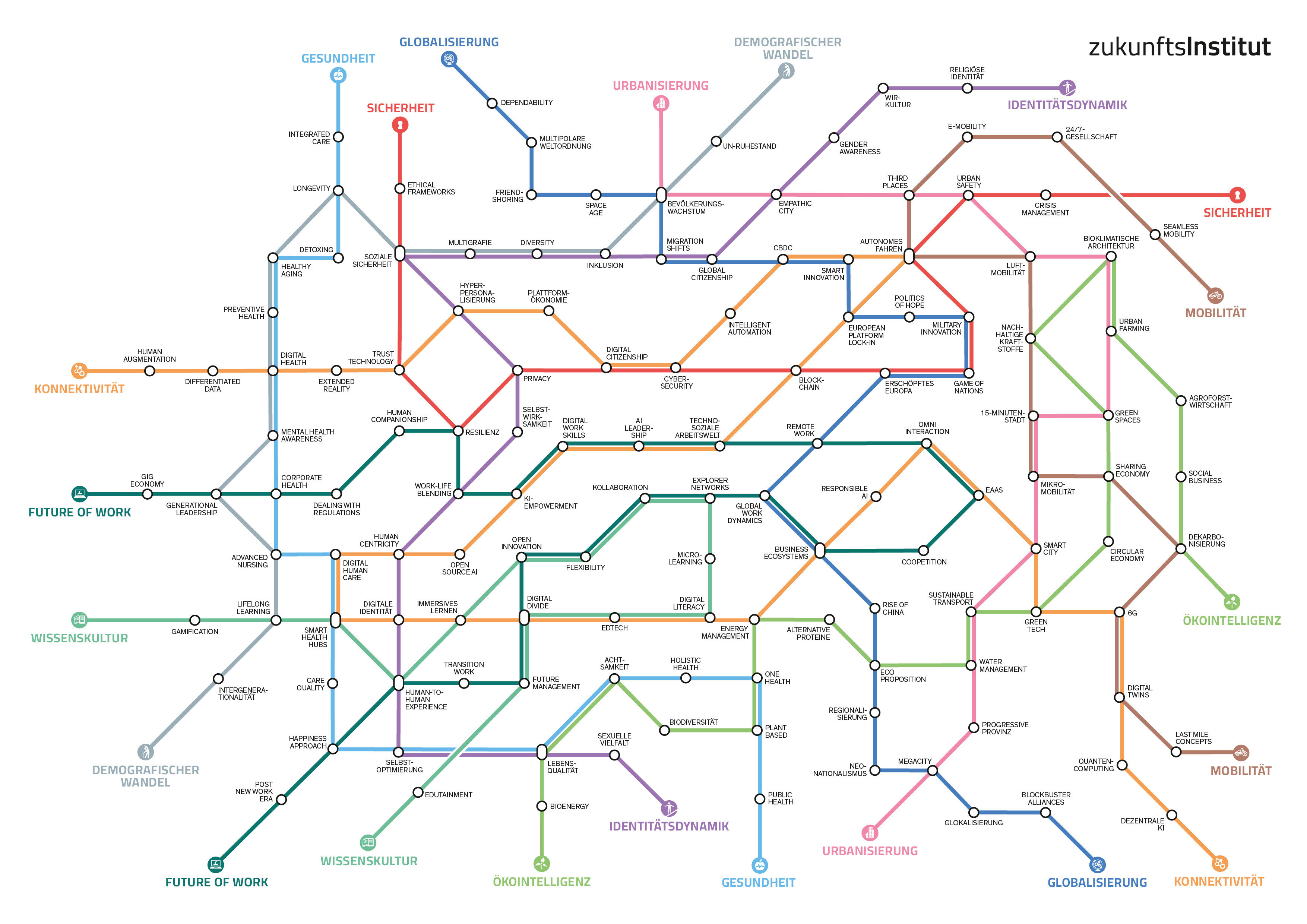

Die Megatrend-Map

| March 12, 2024

Die Megatrend-Map zeigt die 11 zentralen Megatrends unserer Zeit. Sie sind die größten Treiber des Wandels in Wirtschaft und Gesellschaftund prägen..

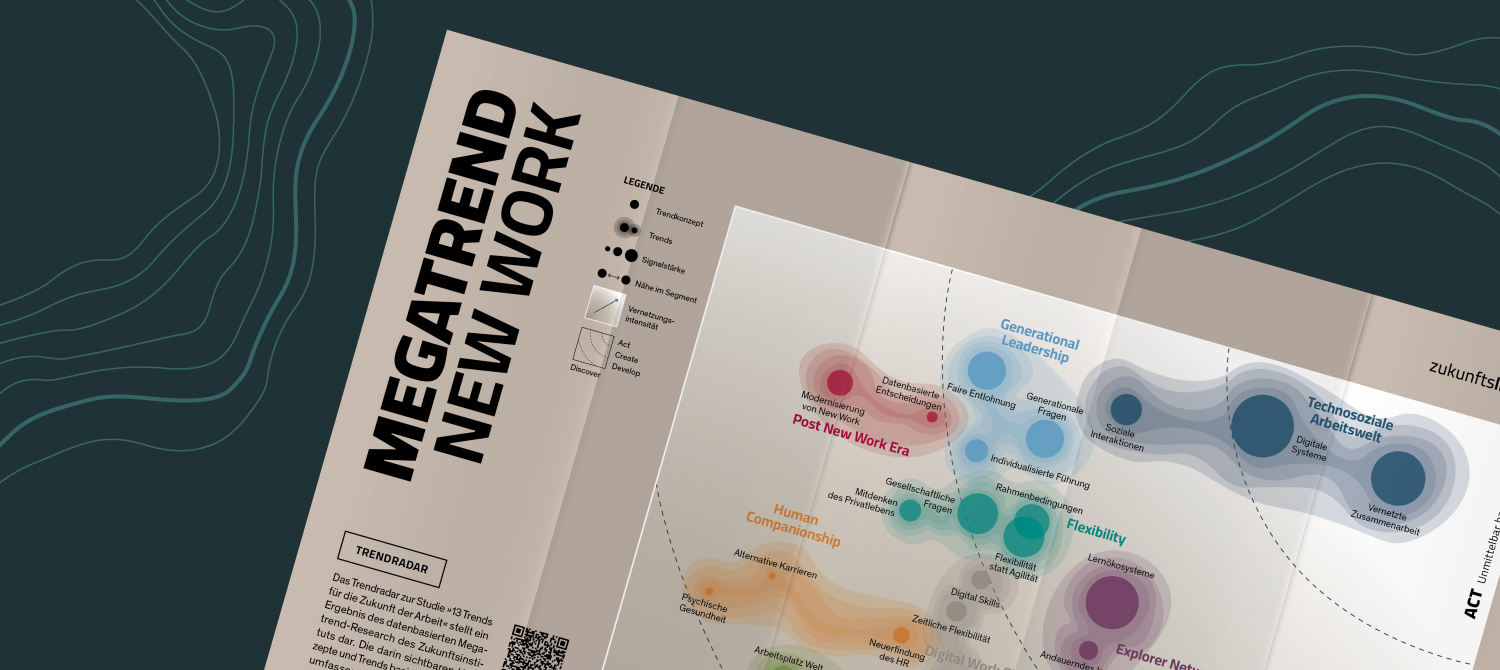

Trendradar Megatrend New Work: Die Zukunft der Arbeit auf einen Blick

| March 12, 2024

Das Trendradar aus der Megatrendstudie 13 Trends für die Zukunft der Arbeit stellt ein Ergebnis des datenbasierten Megatrend-Research des..

New Work Trend Technosoziale Arbeitswelt

| March 7, 2024

Die Technosoziale Arbeitswelt, oft als Arbeit 4.0 bezeichnet, repräsentiert eine fundamentale Veränderung, wie wir Arbeit verstehen und organisieren...

Mental Health @ Work

| January 26, 2024

Was ist Mental Health? Mentale Gesundheit bezieht sich auf den Zustand des emotionalen, psychologischen und sozialen Wohlbefindens einer Person. Es..

New Work Trend Generational Leadership

| January 22, 2024

Europas Demografie verändert sich rapide. Zwar wird schon seit Jahrzehnten über die demografische Pyramide diskutiert, nun aber werden die..

New Work Trend Explorer Networks

| January 22, 2024

Die Innovationsfähigkeit von Unternehmen hängt künftig davon ab, ob und wie sie in Innovationsnetzwerken und -ökosystemen agieren. Unsere..

Future Management: Die neue Rolle in Organisationen

| December 20, 2023

Was ist Future Management? – Eine Definition Future Management umfasst alle Maßnahmen und Handlungen, um die Zukunftsfähigkeit von Organisationen zu..

Die wegweisenden Handelstrends im Überblick

| December 19, 2023

Der Handelssektor steht vor Transformationen, die sowohl durch technologischen Fortschritt als auch durch ein wachsendes Bewusstsein für..

Trendradar Retail: Wichtige Entwicklungen für den Handel

| December 19, 2023

Das Trendradar aus dem aktuellen Retail Report stellt ein Ergebnis des datenbasierten Trend Research Retail des Zukunftsinstituts dar. Die darin..

New Work Trend Human Companionship: Die Evolution von HR

| December 19, 2023

In zukünftigen technosozialen Arbeitswelten, in denen Technologie und Sozialität nahtlos interagieren, ist es für Unternehmen essenziell, den..

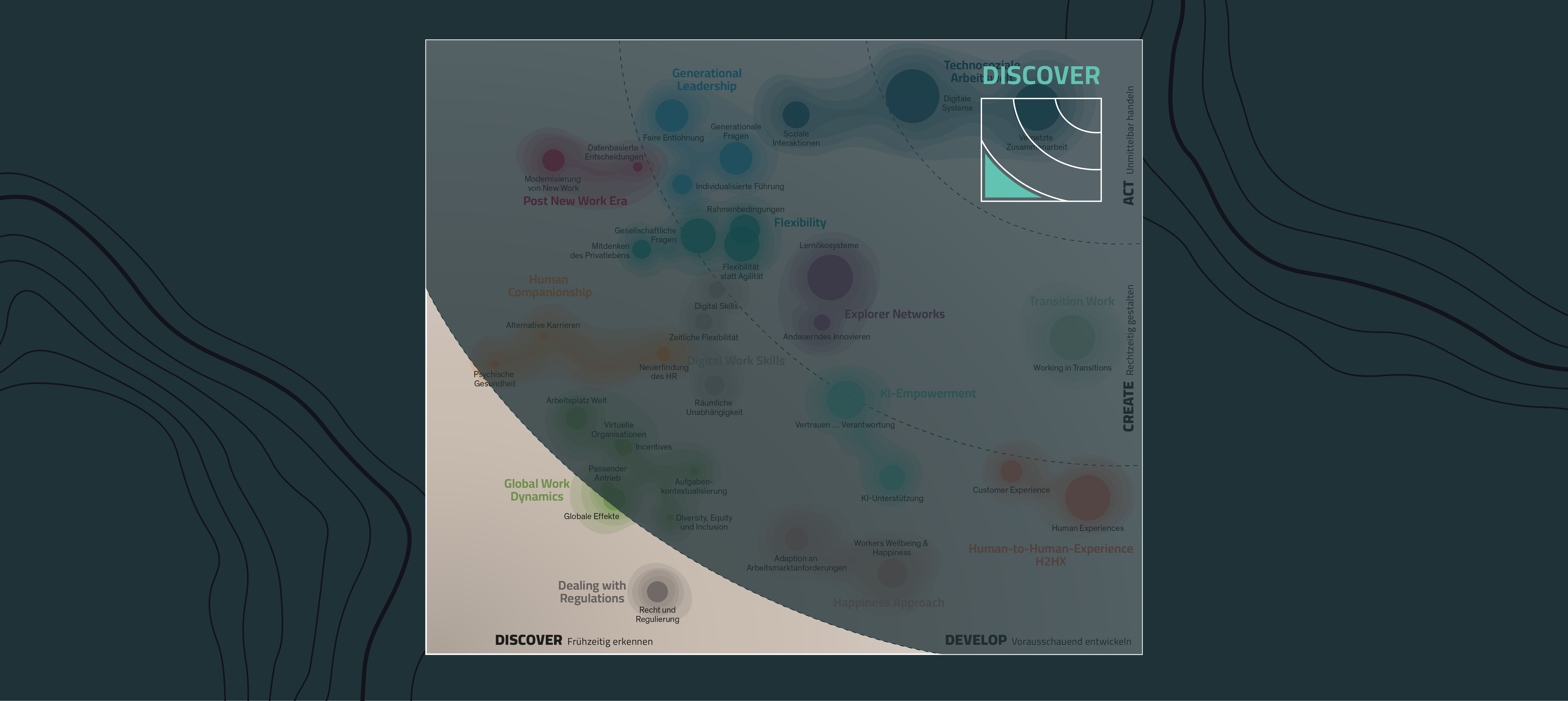

Discover: New Work Trends mit Pionierpotenzial

| December 19, 2023

Als Abbildung unserer Research-Ergebnisse zum Megatrend New Work sind auf dem Trendradar New Work wertvolle Erkenntnisse für Unternehmen abzulesen...

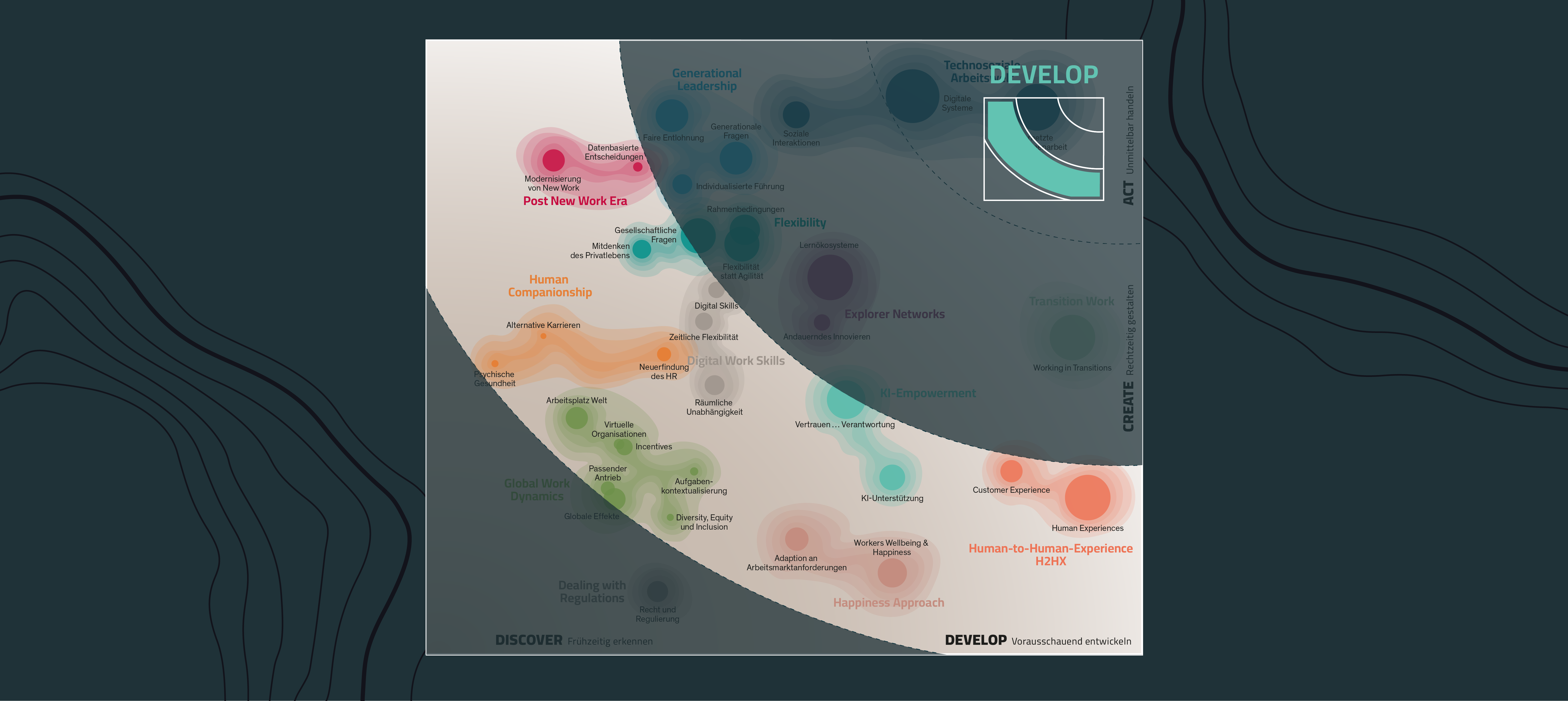

Develop: Für welche New Work Trends Sie Strategien entwickeln sollten

| December 19, 2023

Als Abbildung unserer Research-Ergebnisse zum Megatrend New Work sind auf dem Trendradar New Work wertvolle Erkenntnisse für Unternehmen abzulesen...

Create: Für welche New Work Trends Sie Maßnahmen gestalten sollten

| December 19, 2023

Als Abbildung unserer Research-Ergebnisse zum Megatrend New Work sind auf dem Trendradar New Work wertvolle Erkenntnisse für Unternehmen abzulesen...

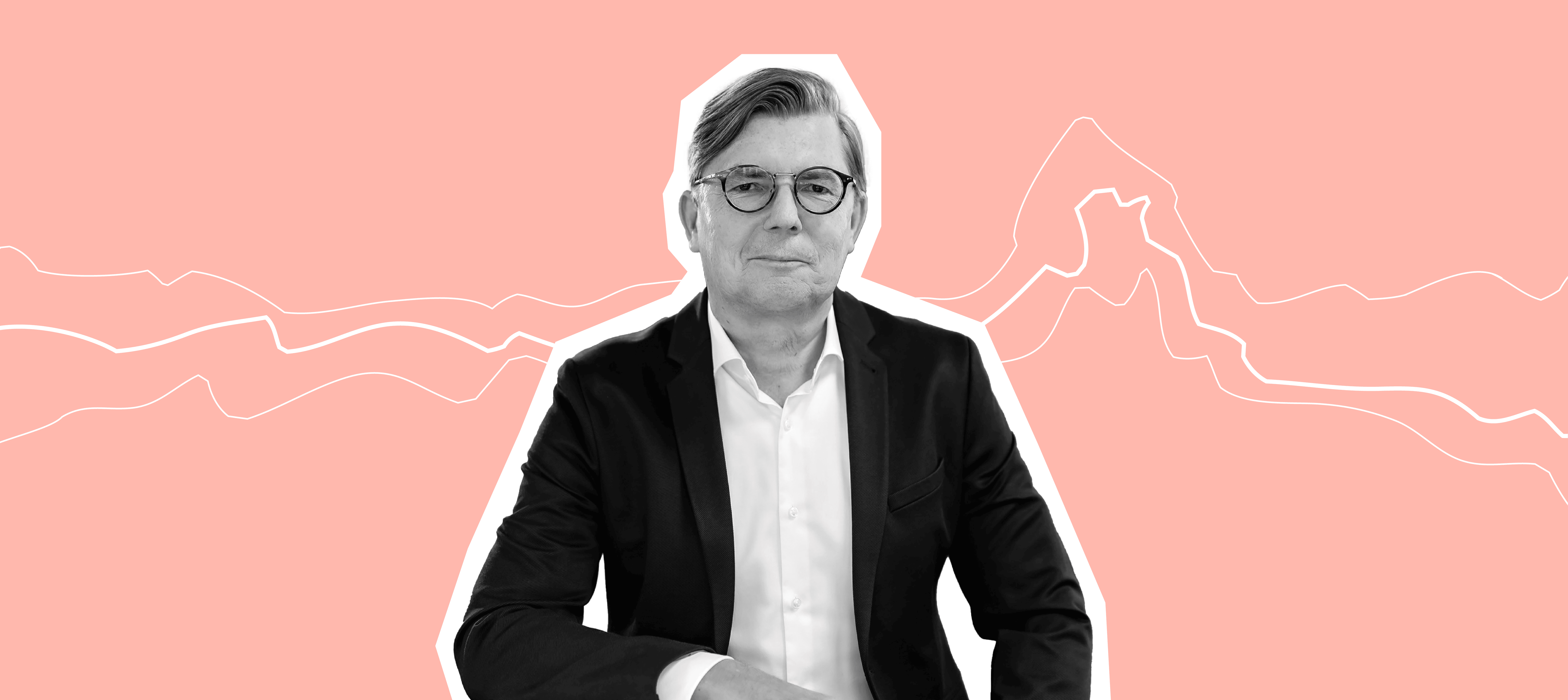

HR und Leadership in der technosozialen Arbeitswelt

| December 18, 2023

Jörg Staff ist Vorstand der deutschen Gesellschaft für Personalführung (DGFP), Aufsichtsrat, renommierter Autor und Speaker, Investor und Executive..

Zukunft der Apotheke: Chancen, Trends und Transformationspotenziale

| December 16, 2023

Herausforderungen und Chancen für Apotheken Klassische Apotheken stehen massiv unter Druck: Die Konkurrenz durch Online-Apotheken stellt ebenso eine..

Gesundheitsmärkte mit großem Zukunftspotenzial

| December 16, 2023

In der sich ständig wandelnden Gesellschaft spielt die Gesundheit eine immer wichtigere Rolle. Diese Entwicklung bietet für innovative Unternehmen,..

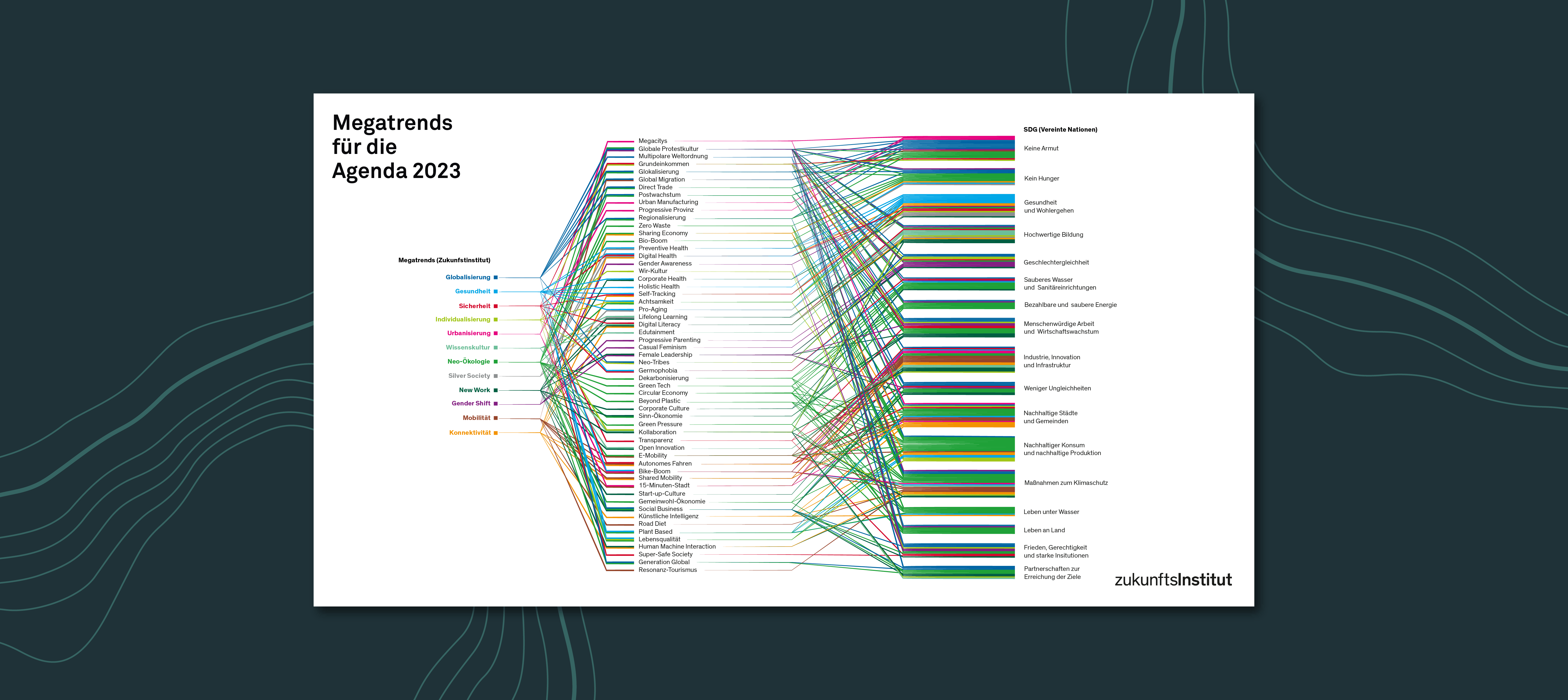

Megatrends meets SDG: Treiber für Nachhaltigkeit

| December 16, 2023

Ein freies und friedliches Leben in Wohlstand auf einem gesunden Planeten für alle Menschen: Um diese Vision einer resilienten Weltgemeinschaft im..

3 Trends als Treiber für nachhaltigen Konsum

| December 16, 2023

Das fragile Konstrukt unserer Konsumwelt, die lange geprägt war von der unreflektierten, verschwenderischen Nutzung von Ressourcen, hat in seinen..

Die treibenden Kräfte hinter der blauen Transition

| December 16, 2023

Wandel und Neues entstehen durch menschliches Handeln – das durch starke Motive aktiviert wird. Das gilt besonders für jenes Handeln, das den Status..

Lebensmittelverpackung: Innovative Alternativen zu Plastik

| December 16, 2023

Wir leben in der „Plastikzeit“: Nützliche Produkte aus Kunststoff umgeben uns, aber auch immenser Plastikmüll. Die radikale Wende der..

Zukunft der Geschlechterrollen

| December 16, 2023

Der Megatrend Gender Shift schafft neue Märkte – und erschüttert die Gesellschaft. Es ist eine Entwicklung, die keineswegs nur Frauen betrifft,..

Von Gendering über Unisex zu Post Gender

| December 16, 2023

Das traditionelle Geschlechtermodell, das Lebensstile, Spielzeug, Kleidung, Berufe, Bücher und vieles mehr nach Geschlecht trennt, verliert zunehmend..

Sechs Beispiele für zukunftsfähige FemTech-Anwendungen

| December 16, 2023

Sechs Best-Practices aus aller Welt, die zeigen, wie moderne und zukunftsfähige FemTech-Modelle die digitalisierte Gesundheitswelt erobern: 1...

Micro-Influencer: Die Ära der passiven Audience ist vorbei

| December 16, 2023

Virtuelle Begegnungen: Je spezieller, desto intensiver Echte Menschen, die bereits eigene Communitys aufgebaut haben, werden zu Markenbotschaftern:..

Kreativität: Das große Missverständnis

| December 16, 2023

Peak Creativity: Kreativität als Massenware Schon lange gilt Kreativität als ein zentraler Treiber des modernen Wirtschaftssystems. Der Bestand von..

Sober Curiosity – den Verzicht genießen

| December 16, 2023

Der Verzicht auf Alkohol wird zum hippen Statement. Doch was genau steckt dahinter? Immer mehr Menschen machen die Erfahrung, dass Alkohol sich zwar..

Was macht Menschen neugierig?

| December 16, 2023

Die neuen Herausforderungen der sich verändernden Wirtschaft erfordern Unternehmen und damit Mitarbeiter, die neugierig sind. Die zu finden darf kein..

Der Lebensstil Moderner Nomade verkörpert das urbane Mindset

| December 16, 2023

Niemand steht so sehr für das urbane Mindset wie der „Moderne Nomade“. Er genießt diese Ungezwungenheit, gestaltet die Dynamik großer Städte aber..

Das leise Comeback des Landes

| December 16, 2023

Unablässig erhöht sich die Leuchtkraft der Städte. Unwiderruflich wachsen die „Schwarmstädte“, in denen Kreativität und Komplexität ein..

Die Zukunft des Landes

| December 16, 2023

Das Interessengebiet der Zukunftsforschung ist gemeinhin die Stadt. Hier findet Innovation statt, hier entsteht Neues, hier treffen Menschen..

Was bedeutet gesunde Ernährung für die Generationen Y und Z?

| December 15, 2023

Gesundheit ist heute das Synonym für ein gutes Leben. Als wichtiges Lebensziel hat sich dieser mächtige, stabile Megatrend tief in unser Bewusstsein,..

Resilienz: Zukunftskraft für Mensch, Gesellschaft, Wirtschaft und Planet

| December 15, 2023

Der Modus der Krise ist zum festen Bestandteil einer neuen Normalität geworden. Die Netzwerkgesellschaft bietet keine langfristig stabilen oder..

Soziale Kipppunkte im Kampf gegen den Klimawandel

| December 15, 2023

Wer sich intensiv mit den Auswirkungen der globalen Erhitzung auseinandersetzt, kann allzu leicht verzweifeln. Uns rennt die Zeit davon. Und im..

Es gibt kein Zurück zur Natur

| December 15, 2023

Herr Dr. van Mensvoort, in Ihrer Forschung beschäftigen Sie sich intensiv mit dem menschlichen Verständnis von Natur. Was ist Ihre Definition von..

Der Mensch ist das großartigere System.

| December 15, 2023

Frau Prof. Dr. Spiekermann, wie intelligent ist KI eigentlich? Sarah Spiekermann: Ob man nun von „Künstlicher Intelligenz“ spricht oder nicht: Jede..

E-Food leitet Strukturwandel in allen Food-Branchen ein

| December 15, 2023

Im Zuge der Pandemie hat E-Food auch im deutschsprachigen Raum an Fahrt aufgenommen. Am offensichtlichsten zunächst mit Blick auf den..

Silverpreneure: Vom Beruf zur Berufung

| December 15, 2023

Raus aus dem Beruf, rein in die Rente, endlich die Füße hochlegen? Dieses Klischeebild einer passiven Seniorenexistenz ist für Silverpreneure, zu..

Alter ist eine Illusion

| December 15, 2023

Alter ist eine Vorstellung von sich selbst, die sich verselbständigt. Wir schaffen uns eine Identität, die sich an individuellen Eckpunkten..

Keine Angst vor Tools!

| December 15, 2023

Es gibt viele Kompetenzen, die wir im 21. Jahrhundert neu entdecken und erlernen müssen. Paradoxie-Kompetenz zum Beispiel: der Umgang mit extrem..

Die Zukunft des Fahrrads

| December 15, 2023

Das Fahrrad reüssiert als urbanes Verkehrsmittel Die Corona-Krise hat die immensen Potenziale des Radfahrens aufgezeigt, denn während der ÖPNV in..

Drohnen-Boom: Die Stunde der Überflieger

| December 15, 2023

Fast täglich laufen Nachrichten über neue Einsatzgebiete von Drohnen über die Bildschirme und spalten die Gesellschaft in vehemente Skeptiker oder..

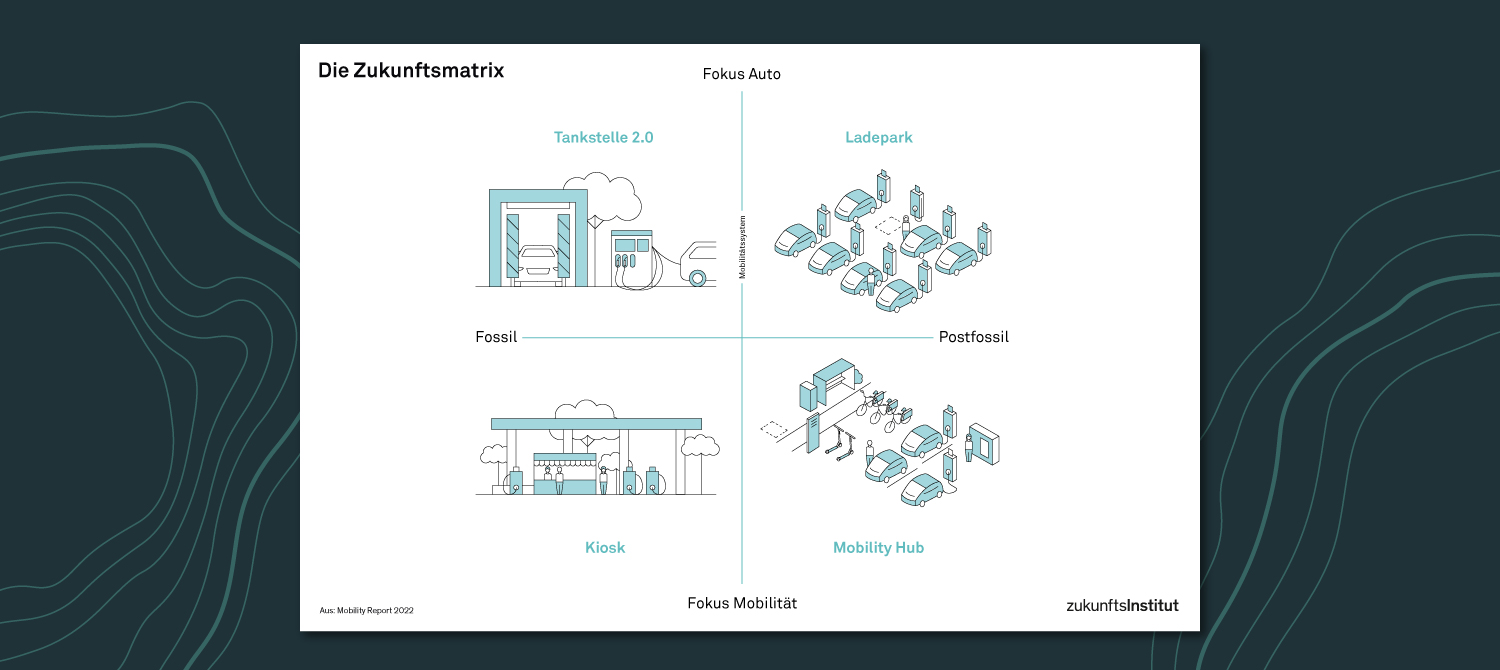

Die Tankstelle der Zukunft: 4 Szenarien

| December 15, 2023

Ändern sich die Anforderungen an die energetischen Bedingungen und an die Mobilität der Zukunft, müssen sich auch die Tankstellen verändern, um..

Das Krankenhaus der Zukunft: 4 Szenarien

| December 14, 2023

Das Jahr 2020 hat die Probleme der Gesundheitssysteme rund um den Globus wie mit einem Brennglas hervorgehoben. Im Fokus der Aufmerksamkeit: Die..

7 Megatrends, die unser Essen besonders stark prägen

| December 14, 2023

Essen ist ein Totalphänomen, das bis zur Unkenntlichkeit mit der Gesellschaft verwoben ist. Das bedeutet, dass sich alle Aspekte des..

Mobility Hubs: Kernelemente der urbanen Verkehrsplanung

| December 14, 2023

Was ist ein Mobility Hub? Was über digitale Plattformen bereits funktioniert, wird auf den physischen Raum übertragen: Mobility Hubs bündeln..

Das Dorf der Zukunft: 6 mögliche Typen

| December 14, 2023

Bis ins 20. Jahrhundert hinein war das Landleben keine Lifestyle-Entscheidung, sondern eine Wirtschaftsform. Auf dem Dorf waren Wohnen und Arbeiten –..

Neo-Tribes

| December 14, 2023

Der Begriff des Neo-Tribalismus geht auf den französischen Soziologen Michel Maffesoli zurück, der in seinem Buch „Le Temps des Tribus“ aus dem Jahr..

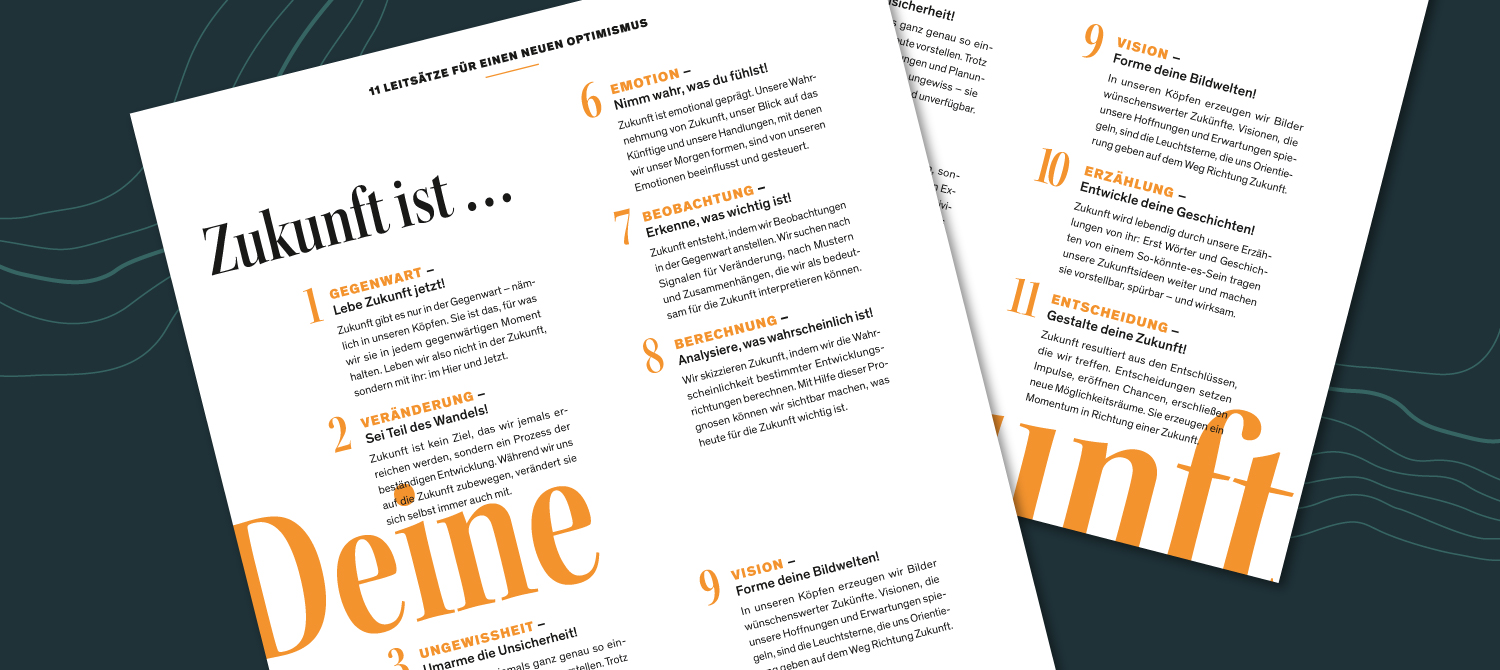

Was ist Zukunft? – 11 wertvolle Erkenntnisse

| December 14, 2023

Zukunft ist das, was es noch nicht gibt. Daher ist Zukunft nie real, sondern eine Imagination in unserem Kopf. Ein Gedankenkonstrukt, das wir heute,..

Nachhaltige Mobilität gestalten: 3 strategische Handlungsfelder

| December 14, 2023

Der Green Deal der Europäischen Kommission hat die Notwendigkeit zum nachhaltigen Wirtschaften in entsprechende Gesetzestexte gegossen. Innerhalb der..

Zukunft der Luftfahrt: 4 Szenarien, wie wir 2040 fliegen werden

| December 14, 2023

Die Luftfahrtbranche erlebt einen Sky Blues: Auf der Kurzstrecke werden durch Klimawandel und Flugscham immer häufiger Bahn oder Reisebus genutzt...

Mobilitätsbudget: Benefit für Unternehmen & Mitarbeitende

| December 14, 2023

Was ist das Mobilitätsbudget und wie funktioniert es? Das Mobilitätsbudget ist eine zeitgenössische und nachhaltige Alternative zum Pendeln mit dem..

Die Evolution der Medien

| December 14, 2023

Medien begleiten die Menschheitsgeschichte von Anbeginn an. Seit unsere Vorfahren vor hunderttausend Jahren mit Faustkeilen die ersten Symbole in..

Trend: Erschöpftes Europa

| December 14, 2023

Wir befinden uns in einer neuen, globalen Wirklichkeit. Die lang gehegte Idee einer europäischen Vorreiterrolle bröckelt in vielen Bereichen. Nicht..

5 Globalisierungs-Trends, die Unternehmen kennen müssen

| December 14, 2023

Trends sind keine statischen Phänomene, sie befinden sich in einer permanenten Evolutionsschleife. Die Ergebnisse der turnusgemäßen Überprüfung des..

Grenzen überschreiten – individuell, organisational, gesellschaftlich

| December 14, 2023

Ob wir es bemerken oder nicht: Tag für Tag ziehen wir Striche. Wir unterscheiden und markieren, differenzieren, ordnen ein, filtern Relevantes von..

China im Aufstieg: Ambivalenz und Strategien für Europa

| December 14, 2023

China ist komplex und damit ist auch die Art und Weise, wie Politik und Unternehmen mit der Volksrepublik umgehen sollen, komplex. Auf der einen..

Trend: vom Nearshoring zum Friendshoring

| December 14, 2023

War in den vergangenen Jahren vor allem die Entwicklung vom Off- zum Nearshoring zu beobachten, so ist aus den Forschungsergebnissen unserer..

Trend: Eco Proposition – 3 Werte für zukunftsfähige Angebote

| December 14, 2023

Ein Blick in die USA zeigt: Das Umweltbewusstsein ist in allen Altersgruppen der US-Bevölkerung innerhalb der vergangenen Jahre gestiegen – also auch..

Navigieren Sie erfolgreich durch die neue Arbeitswelt

| December 14, 2023

Digitalisierung, Globalisierung und der zunehmende Wunsch nach Flexibilität und Selbstbestimmung verändern die Art, wie wir arbeiten. Um in dieser..

Emotionale Intelligenz im Job: Leitfaden für Führungskräfte

| December 14, 2023

Emotionale Intelligenz ist eines der zentralen Handlungsfelder im Kontext des Megatrends New Work. Führungskräfte, die in diesem Bereich ihre..

Kollaboration als Schlüssel zum Unternehmenserfolg

| December 14, 2023

Kollaboration als unternehmerische Tugend Der Megatrend Konnektivität verändert die Art und Weise, wie wir arbeiten, grundlegend. Digitale Tools..

Mitarbeiterbindung: Der Schlüssel zur erfolgreichen Employee Journey

| December 14, 2023

In jeder Phase der Employee Journey – von der Einstellung, über die Einarbeitung, die Beförderung ja sogar bis hin zum Austritt aus dem Unternehmen..

Digitale Transformation: Strategien für Unternehmen

| December 14, 2023

Die digitale Transformation ist ein zentrales Thema für Führungskräfte, HR-Manager und Business Developer, die den Megatrend New Work in ihrem..

Agiles Arbeiten: Die Vorteile für Unternehmen und Mitarbeitende

| December 14, 2023

Agile Work oder agiles Arbeiten ist einer der wesentlichen Bereiche des Megatrends New Work und damit zentral für Führungskräfte, HR, Business..

Employee Experience: Die Personalabteilung gestaltet Zukunft

| December 14, 2023

Die Employee Experience wird im Zeitalter des Megatrends New Work zu einem der wichtigsten Faktoren für den Erfolg von Unternehmen. Sie beschreibt..

Die Zielgruppe ist tot, es lebe der Lebensstil

| December 13, 2023

Sie sind im selben Jahr in England geboren, sind geschieden, haben wieder geheiratet. Ihre Kinder sind erwachsen und ihr Vermögen ist beträchtlich...

Glossar Demografischer Wandel: Trendbegriffe und Definitionen

| December 13, 2023

A Advanced Nursing Die Pflege wird durch Akademisierung und neue Rollen professionalisiert, entlastet das Gesundheitswesen und gewinnt an..

Glossar Future of Work: Trendbegriffe und Definitionen

| December 13, 2023

A AI Leadership AI Leadership integriert Künstliche Intelligenz in Führungsaufgaben, optimiert Entscheidungsprozesse und steigert Effizienz, teils..

OMline: Digital erleuchtet

| December 13, 2023

Die Zeiten, in denen das Internet als Wahrheits-, Demokratie- und Wissensmedium gefeiert wurde, sind längst vorbei. Die unkritische Euphorie der..

Konnektivität: Die Vernetzung der Welt

| December 13, 2023

Internet und Digitalisierung durchdringen alle Bereiche des menschlichen Lebens und verändern Gesellschaft, Ökonomie und Kultur. Das Netz ist längst..

Healthness: Gesundheit wird ganzheitlich

| December 13, 2023

Die selbstreflexive, individualisierte Gesundheit der Selfness-Phase geht in den kommenden Jahren in einen neuen Ansatz über. Über aktive..

Pioniere des Wandels: 3 digitale Lebensstile

| December 13, 2023

Digitalisierung ist längst Teil unseres Alltags und bietet uns tagtäglich eine Fülle von Möglichkeiten und Herausforderungen. Die Vernetzung..

Essen neu bewertet: 3 Lebensstile mit kulinarischer Vorliebe

| December 13, 2023

Die lebendige Geschichte und das sinnliche Erleben unseres Essens rücken immer mehr ins Zentrum des Interesses. Der direkte Kontakt mit Händlern und..

Die Potenziale der Globalisierung

| December 13, 2023

Auch wenn die Globalisierung so alt ist wie die Menschheit selbst: Die Machtverschiebungen in Richtung Asien, der Aufbruch Südamerikas, die..

Pioniere zukünftiger Wohnkonzepte

| December 13, 2023

Häufig bestimmen andere – Architekten, Stadtplaner oder Immobilienentwickler – wie wir leben und auch in Zukunft leben werden. Das entspricht aber..